「ビデオ会議の相手は、本当に本人ですか?」

こんな問いかけが、もはやSF映画の話ではない時代になりました。

2024年、香港である多国籍企業の従業員が、ビデオ会議に登場した偽の最高財務責任者(CFO)に騙され、約40億円を送金してしまうという衝撃的な事件が起きました。 会議に参加していた他の同僚たちも、すべてAIが生成したディープフェイクだったのです。

2026年が目前に迫り、フェイクニュースやディープフェイクは、私たちの想像をはるかに超える速さで進化し、日常に深く静かに浸透し始めています。

この記事では、単なる技術解説に留まりません。読者一人ひとりが、そして大切なビジネスを守るべき企業が、この新たなデジタル社会のリスクにどう備え、信頼をどう守っていくべきか。私の経験も交えながら、具体的なステップを誰にでも分かる言葉で解説していきます。

【2026年最新】もう他人事ではない!私たちの日常に忍び寄るフェイクニュースとディープフェイクの脅威

かつては専門家や国家レベルの脅威と見なされていたディープフェイクは、生成AI技術の民主化により、今や誰でも比較的簡単に作成・悪用できるツールとなりつつあります。その結果、私たちの生活やビジネスを取り巻くリスクは、質・量ともに大きく変化しています。

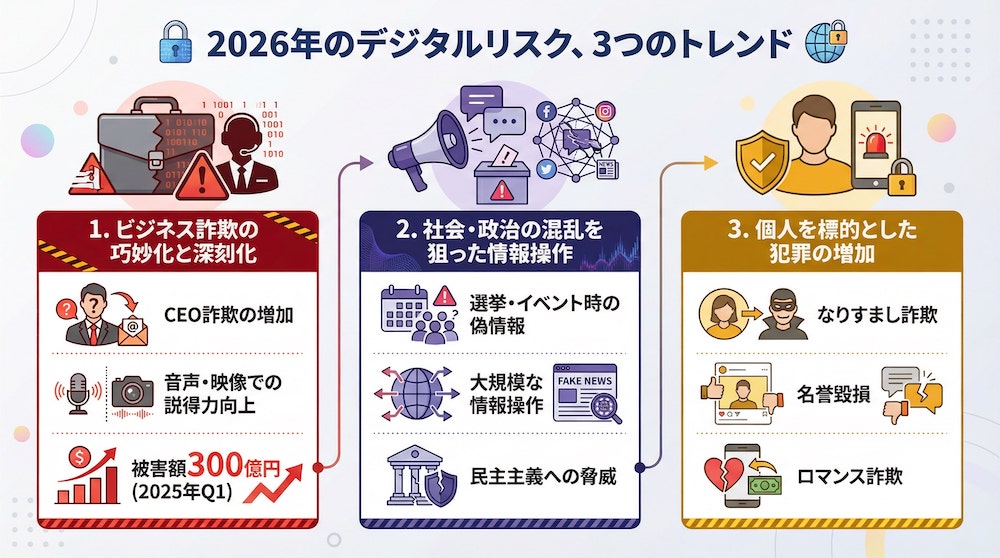

2026年のデジタルリスク、3つのトレンド

2026年以降、私たちが直面するデジタルリスクは、主に3つのトレンドに集約されると考えられます。

1. ビジネス詐欺の巧妙化と深刻化

冒頭で紹介した香港の事例のように、経営層になりすまして従業員を騙す「CEO詐欺」は、音声や映像が加わることで格段に説得力を増しています。2025年のある調査では、第1四半期だけでディープフェイク詐欺による世界的な被害額が300億円近くに達したと報告されており、その脅威の大きさがうかがえます。

参考: 3か月で被害額300億円、深刻化する「ディープフェイク」詐欺の現状と課題

2. 社会・政治の混乱を狙った情報操作

国政選挙や国際的なイベントに乗じて、特定の候補者や国家をおとしめるための偽情報が拡散されるリスクは常に存在します。ディープフェイク技術は、こうした情報操作をより大規模かつ効果的に行うことを可能にし、民主主義の根幹を揺るがしかねません。

3. 個人を標的とした犯罪の増加

脅威は企業や国家だけに向けられるわけではありません。知人の声や姿を悪用した「なりすまし詐欺」や、個人の画像を悪用した名誉毀損、ロマンス詐欺など、より個人的なレベルでの被害が深刻化することが予測されます。

事例1:あなたの声を数秒で複製。巧妙化する「音声なりすまし詐欺」

「もしもし」と電話に出た、わずか数秒の音声。

それだけで、あなたの声そっくりの音声をAIが作り出し、家族に「事故に遭ったからお金を振り込んで」と電話をかける。そんな詐欺が現実のものとなっています。

デジタル本人確認や不正防止技術を手がけるIDwall社によると、最新のAIはわずか3秒の音声サンプルがあれば、その人の声のトーンや話し方の癖まで高精度で模倣できると警鐘を鳴らしています。実際に、経営者の声を複製して従業員に送金を指示するCEO詐欺で、多額の被害が発生したケースも報告されています。

私がブランドセキュリティ部門にいた頃、SNSの些細な書き込みから個人を特定し、嫌がらせを行う手口を数多く見てきました。今や、SNSに投稿した動画の音声データが、こうした詐欺に悪用されるリスクと隣り合わせなのです。

事例2:オンライン面接に現れた「偽の候補者」。ディープフェイク採用詐欺の実態

リモートワークの普及に伴い、オンライン面接は当たり前になりました。しかし、その裏で新たなリスクが生まれています。それが「ディープフェイク採用詐欺」です。

これは、応募者がディープフェイク技術を使い、別人の顔や声で面接を受ける手口です。目的は、経歴を偽って企業に潜入し、機密情報を盗み出したり、不正に給与を得たりすることにあります。

こちらの記事によると、全世界の企業の約半数が、採用プロセスで何らかのディープフェイクを経験したと回答しており、すでに看過できない問題となっています。

この手口が厄介なのは、単なる技術的な問題に留まらない点です。採用という企業の根幹をなすプロセスが偽りによって侵害されることは、内部セキュリティの崩壊や、長期的なブランド価値の毀損に直結します。ブランドセキュリティの専門家として、これは「見えない内部からの脅威」であり、従来の対策だけでは防ぎきれない、非常に深刻なリスクだと断言できます。

なぜ見抜けない?生成AIが作る「巧妙な偽情報」の仕組みとリスク

「注意深く見れば、偽物だと分かるはず」

そう思う方もいらっしゃるかもしれません。しかし、現在のディープフェイク技術は、人間の認知能力の限界を巧みに突いてきます。なぜ私たちは、いとも簡単に騙されてしまうのでしょうか。

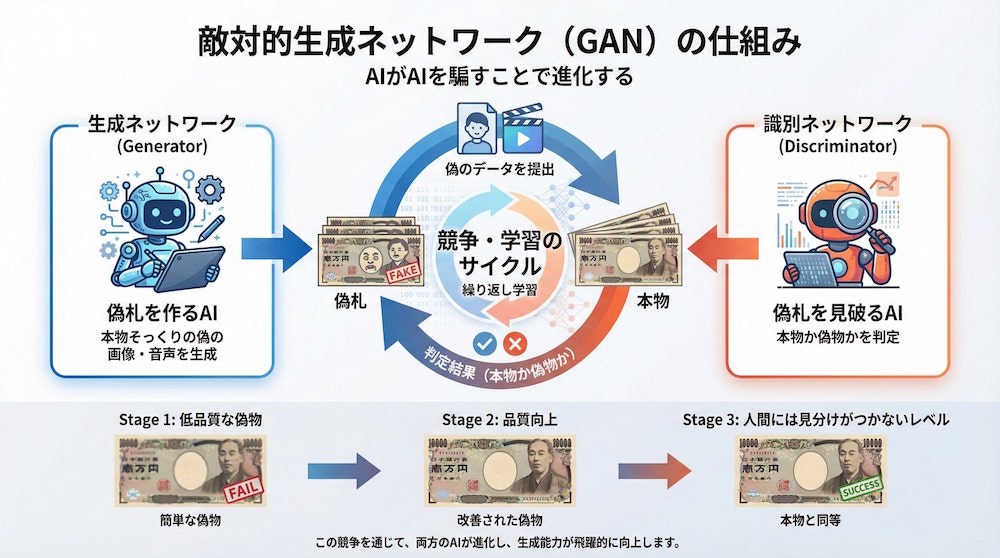

「敵対的生成ネットワーク(GAN)」とは?AIがAIを騙すことで進化する

ディープフェイクの精度を飛躍的に向上させた中核技術の一つに、「GAN(ギャン)」と呼ばれるAIの仕組みがあります。

GANを分かりやすく例えるなら、「偽札を作るAI」と「それを見破るAI」が、互いに競い合いながら学習していくようなものです。

- 生成ネットワーク (Generator): 本物そっくりの偽の画像や音声(偽札)を作ろうとします。

- 識別ネットワーク (Discriminator): 生成ネットワークが作ったものが本物か偽物か(偽札かどうか)を判定します。

この2つのAIが、お互いを騙そうと競争を繰り返すことで、生成ネットワークはどんどん精巧な偽物を作り出す能力を高めていきます。この終わりのない競争の結果、人間の目ではほとんど見分けがつかないレベルのディープフェイクが生まれます。

見分けるのが困難な理由:人間の脳の「クセ」を悪用する

技術的な精巧さに加え、偽情報が広まる背景には、私たち人間が持つ「認知バイアス」という脳のクセが大きく関わっています。

例えば、以下のような心理が、偽情報への抵抗力を弱めてしまいます。

| 認知バイアス | 説明 |

|---|---|

| 正常性バイアス | 自分にとって都合の悪い情報を無視したり、過小評価したりする傾向。「まさか自分が騙されるはずがない」と思い込んでしまう。 |

| 確証バイアス | 自分の考えや信念を支持する情報ばかりを探し、反対の情報を無視する傾向。信じたい情報を無批判に受け入れてしまう。 |

| 感情ヒューリスティック | 好きか嫌いか、心地よいか不快かといった感情的な反応で、物事を判断してしまう傾向。怒りや感動を煽る情報は、冷静な判断を妨げやすい。 |

私が風評被害対策の現場で見てきたネット炎上も、多くがこうした認知バイアスによって加速していました。人々は「信じたいもの」を信じ、「共有したい」という感情に突き動かされて情報を拡散します。ディープフェイクは、この人間の心理的な脆弱性を、映像や音声という非常に強力な形で悪用するのです。

【個人でできる対策】今日から始めるデジタルセルフディフェンス術

では、この見えない脅威に対して、私たちは無力なのでしょうか。決してそんなことはありません。特別なツールやスキルがなくても、日々の情報との向き合い方を少し変えるだけで、リスクを大幅に減らすことができます。今日から始められる3つのステップをご紹介します。

STEP1:まず疑う。「本当かな?」と思う習慣を身につける

情報に触れたとき、特に自分の感情が大きく揺さぶられた(怒り、恐怖、感動など)ときこそ、一度立ち止まることが最も重要です。

「これは本当だろうか?」

「あまりに話が出来すぎていないか?」

反射的に信じたり、シェアしたりする前に、一呼吸おいて自問自答する習慣をつけましょう。これは、情報の真偽を見抜くための第一歩であり、最も効果的な防衛策です。

STEP2:情報源を確認する。誰が、何のために発信している?

次に、その情報が「どこから」発信されたものなのかを確認します。内閣官房も、偽情報対策として情報源の確認を推奨しています。

【初心者向けチェックリスト】

- 発信者は誰?: 個人のアカウントであれば、プロフィールや過去の投稿を見て、信頼できる人物か確認しましょう。「AIアーティスト」などと自己紹介している場合もあります。

- 公式サイトや一次情報は?: 企業や公的機関に関する情報であれば、必ず公式サイトの発表を確認しましょう。

- URLは正しい?: 有名メディアや企業を装った偽サイトも存在します。URLのスペルが微妙に違っていないかなどを確認しましょう。

- 根拠は示されている?: 「関係者によると」「専門家が指摘」といった曖昧な表現だけでなく、具体的なデータや出典が示されているかを確認します。

STEP3:複数の情報源を比較する。一次情報や信頼できるメディアを参照

一つの情報だけを鵜呑みにせず、同じテーマについて他のメディアがどう報じているかを確認する「クロスチェック」が非常に有効です。

例えば、衝撃的なニュースに触れたら、複数の大手新聞社や通信社のサイト、テレビ局のニュースサイトなどを確認してみましょう。もし、その情報について他の信頼できるメディアが一切報じていない場合、それは偽情報である可能性が高いと言えます。

また、国内外のファクトチェック専門機関が提供するサービスを利用するのも一つの手です。Googleの「Fact Check Explorer」や、日本の「日本ファクトチェックセンター(JFC)」などは、情報の真偽を検証する上で役立ちます。

【企業向け対策】ブランドと信頼を守るための5つの必須アクション

個人のリテラシー向上はもちろん重要ですが、企業は組織として、より体系的かつ堅牢な防衛策を講じる必要があります。ブランドと顧客、そして従業員を守るために、今すぐ着手すべき5つのアクションを提案します。

アクション1:認証を強化する。「多要素認証」と「ゼロトラスト」の原則

まず取り組むべきは、技術的な防御の強化です。特に、財務部門や経営層など、金銭や重要情報を取り扱う部署は攻撃者の主要な標的となります。

多要素認証(MFA)の徹底

IDとパスワードだけに頼る認証はもはや安全ではありません。スマートフォンへの通知や生体認証など、複数の要素を組み合わせた認証を、社内のあらゆるシステムで必須にしましょう。

ゼロトラストの導入

「社内は安全、社外は危険」という従来の境界型セキュリティの考え方を捨て、「あらゆるアクセスは信用しない」を前提とする「ゼロトラスト」モデルへの移行が急務です。これは、すべてのアクセス要求に対して、その都度厳格な認証と認可を行うことで、たとえ社内ネットワークに侵入されても被害を最小限に食い止める考え方です。

アクション2:従業員の意識を変える。「見分けられない」前提の訓練を

「ディープフェイクは、もはや人間の目では見分けられない」

この事実を、経営層から現場の従業員まで、全社で共通認識として持つことが重要です。精神論で「注意しろ」と呼びかけるだけでは不十分です。

実践的なセキュリティ訓練

偽のCEOから送金指示のメールが届く、といった具体的なシナリオに基づいた模擬訓練(フィッシング訓練など)を定期的に実施しましょう。

ルールの徹底

特に高額な送金や機密情報の開示依頼があった場合は、「メールやビデオ会議の指示だけで実行しない」「必ず別の経路(登録済みの電話番号にかけるなど)で本人確認を行う」といったルールを定め、徹底することが不可欠です。

アクション3:インシデント対応計画を立てる。被害発生後のシナリオ

どれだけ対策を講じても、被害に遭う可能性をゼロにすることはできません。重要なのは、被害が発生した「後」に、いかに迅速かつ的確に対応し、ダメージを最小限に抑えるかです。

事前に、法務、広報、経営層、情報システム部門などを巻き込んだ対応チームを組成し、具体的な対応手順を記した「プレイブック」を準備しておきましょう。誰が指揮を執り、どこに連絡し、顧客やメディアにどう説明するのか。シナリオを具体的に定めておくことが、有事の際のブランド失墜を防ぐ生命線となります。

アクション4:グローバル規制に備える。EU AI Actへの先行対応

2026年は、AI規制の大きな転換点となります。特に「EU AI Act(AI法)」は、2026年8月頃から大部分の規定の適用が開始される予定で、日本企業にとっても決して他人事ではありません。

参考: 「欧州(EU)AI規制法」の解説―概要と適用タイムライン・企業に求められる対応

この法律は、EU市場でAIシステムを提供する、あるいは利用する事業者に適用されるため、EUに顧客を持つ日本企業は対応が必須となります。自社がどのようなAIシステムを利用・提供しているかを今のうちから棚卸しし、リスク評価を行うなど、先行的な対応が求められます。

違反した場合には、全世界の売上高の数%に及ぶ高額な制裁金が科される可能性もあります。

アクション5:自社の「本物」を証明する。公式サイトやSNSでの積極的な情報発信

これまでは「守り」の対策についてお話してきましたが、偽情報への最も強力な対抗策の一つは、平時から「攻め」の情報発信を行うことです。

公式サイトや公式SNSアカウントを通じて、正確な情報を積極的に、そして継続的に発信し続けることで、顧客や社会との間に「信頼の貯金」を築いておくのです。万が一、自社に関する偽情報が流れたとしても、普段から信頼関係が構築されていれば、人々は「公式の情報が本物だ」と判断しやすくなります。

これは、結果的に偽情報が拡散するのを防ぐ、強力な防波堤となるのです。

「本物」をどう証明する?C2PAと電子透かしが拓く未来

個人のリテラシーや企業の対策と並行して、コンテンツそのものが「本物である」ことを証明するための技術開発も進んでいます。その代表格が「C2PA」です。

コンテンツの「身分証明書」:C2PAの仕組みとは

C2PA(Coalition for Content Provenance and Authenticity)は、Adobe、Microsoft、Intelなどが主導する、コンテンツの来歴と真正性を証明するためのオープンな技術標準です。

これを分かりやすく例えるなら、デジタルコンテンツに付けられる「産地証明書」や「製造履歴」のようなものです。

画像が撮影されたとき、あるいはAIで生成されたときに、その作成者、日時、場所、使用されたツール、その後の編集履歴といった情報(メタデータ)が、改ざん困難な形でファイルに埋め込まれます。

これにより、私たちはコンテンツを見たときに、それが「いつ、誰が、どのようにして作ったものか」を確認できるようになり、偽情報かどうかを判断する客観的な手がかりを得ることができます。

限界と今後の展望:2026年時点での課題

C2PAは非常に有望な技術ですが、万能ではありません。

例えば、SNSプラットフォームによっては、画像をアップロードする際にメタデータが削除されてしまうことがあります。また、C2PAに対応したカメラやソフトウェアが普及するには、まだ時間がかかります。

しかし、こうした技術が「信頼のインフラ」として社会に定着していくことは間違いありません。2026年以降、私たちは技術とリテラシーの両輪で、デジタル空間の信頼性を担保していくことになるでしょう。

よくある質問(FAQ)

Q: ディープフェイク動画は、簡単に見分けることができますか?

A: 残念ながら、2026年現在、人間の目で簡単に見分けることは非常に困難です。AI技術の進化により、瞬きや息遣い、細かな表情まで自然に再現されるためです。だからこそ、「見分ける」ことに固執するのではなく、「騙されないための仕組みやルール」を個人・組織で持つことが重要になります。

Q: 自分の写真が勝手に使われないか心配です。何か対策はありますか?

A: SNSに投稿する写真のプライバシー設定を見直すことが第一歩です。公開範囲を友人に限定する、顔がはっきりと写っている写真の投稿は慎重になる、といった対策が考えられます。また、万が一悪用された場合に備え、定期的に自分の名前で画像検索を行い、意図しない使われ方をしていないかチェックすることも有効です。

Q: 会社でディープフェイク詐欺の被害に遭ったら、まず何をすべきですか?

A: まずは送金プロセスを直ちに停止し、警察や弁護士などの専門機関に相談してください。同時に、事前に作成したインシデント対応計画に沿って、社内の対応チームを招集します。事実関係の迅速な把握、顧客や関係者への適切な情報開示など、誠実かつ迅速な対応をとることが、ブランドへのダメージを最小限に抑える鍵となります。

Q: EU AI Actは、日本の企業にも本当に関係があるのですか?

A: はい、大いに関係があります。EU市場に製品やサービスを提供している企業はもちろん、自社のウェブサイトがEU域内からアクセス可能であるだけでも、規制の対象となる可能性があります。 自社のビジネスがどのようにEUと関わっているかを確認し、必要であれば専門家への相談をお勧めします。

まとめ

この記事では、2026年以降本格化するフェイクニュースとディープフェイクの脅威に対し、個人と企業が取るべき具体的な対策について解説してきました。

- 個人ができること: まず疑う習慣、情報源の確認、クロスチェックの実践。

- 企業がすべきこと: 認証強化、従業員教育、インシデント対応計画、規制対応、そして積極的な情報発信。

私がブランドを守る仕事を通じて痛感してきたのは、一度失われた信頼を取り戻すことの難しさです。デジタル空間における「信頼」は、もはや自然に存在するものではなく、私たち一人ひとりが、そして企業が、意識的に「構築し、証明していく」必要があるものへと変わりました。

技術の進化を止めることはできません。しかし、私たちの意識と準備によって、そのリスクを管理し、最小限に抑えることは可能です。

この記事が、皆さんの大切なデジタルライフとビジネスを守るための一助となれば、これほど嬉しいことはありません。