2026年、ビジネスシーンで生成AIの活用が当たり前になる未来。

矢野経済研究所の調査によると、2025年時点で国内企業の4割以上が生成AIを活用しており、その流れは今後さらに加速するでしょう。

しかしその裏で、企業のブランド価値を一瞬で失墜させる新たな炎上リスクが急増しています。

それが、生成AIが引き起こす「LGBTQ+に関する不適切表現」です。

AIは、学習データに含まれる社会の偏見を無意識に増幅させ、意図せず差別的なコンテンツを生み出してしまう危険性を孕んでいます。

私が以前所属していたブランドセキュリティ部門では、企業の評判がいかに繊細で、一度の過ちで崩れ去るかを目の当たりにしてきました。

だからこそ、この新しいリスクに警鐘を鳴らしたいのです。

本記事では、WEBリスク対策の最前線で企業の評判を守ってきた専門家の視点から、なぜ生成AIとLGBTQ+の問題が深刻なのか、具体的な炎上事例と2026年に向けた企業の取るべき対策を、「守り」と「攻め」の両面から分かりやすく解説します。

なぜ今、生成AIとLGBTQ+が新たな炎上火種になるのか?

「AIは中立的なツールだ」そう思っていませんか?

実はその考え方自体が、大きなリスクの始まりです。

生成AIとLGBTQ+の問題が、なぜこれからの企業にとって無視できない炎上の火種となるのか、3つの視点から解説します。

AIは社会の偏見を映す鏡:学習データに潜むバイアスの罠

生成AIは、ゼロから何かを生み出す魔法の箱ではありません。

インターネット上の膨大なテキストや画像を「学習」することで、人間のようなコンテンツを生成します。

問題は、その学習データに、私たちの社会が長年抱えてきたステレオタイプや偏見がそのまま含まれていることです。

特に、歴史的にマイノリティであったLGBTQ+に関するデータは、量・質ともに偏りがあるのが現状です。

例えば、ある研究では、AIにLGBTQ+の人物画像を出力させると、特定の髪型や服装といった画一的なイメージばかりが生成されることが示されています。

これは、AIが「ゲイの男性はこうあるべき」「レズビアンの女性はこうあるべき」といった、社会に根強く残る偏見を学習してしまっている証拠です。

参考: Focus on AI – 2024 Social Media Safety Index | GLAAD

このようなAIが企業のマーケティングや採用活動に使われたらどうなるでしょうか。

意図せずして、特定の層を傷つけ、社会の偏見を再生産してしまうリスクがあるのです。

【ポイント】

AIは中立ではなく、学習データに含まれる社会のバイアスを反映します。特にLGBTQ+に関するデータは偏りが大きく、不適切な表現を生成しやすい構造的問題を抱えています。

「無意識の差別」の増幅:意図しない炎上が急増する理由

「私たちは差別なんてしていない」

多くの企業担当者はそう考えているはずです。

しかし、生成AIがもたらす炎上の恐ろしさは、担当者に悪意がなくても発生する「無意識の差別」にあります。

例えば、広告のキャッチコピーをAIに複数案出させ、その中から最も響きの良いものを選んだとします。

しかし、そのコピーが、知らず知らずのうちに異性愛を前提とした表現になっていたり、特定のジェンダー役割を固定化するようなニュアンスを含んでいたりするかもしれません。

人間の目では見過ごしがちな、こうした些細な表現(マイクロアグレッション)を、AIは大量に、かつ高速に生み出します。

チェック体制が不十分なまま世に出てしまえば、「配慮がない」「時代錯誤だ」といった批判がSNSで一気に拡散し、大規模な炎上につながるのです。

私がブランドセキュリティ部門にいた頃、炎上の多くは悪意からではなく、「無知」や「無配慮」から生まれていました。

生成AIは、この「無知」と「無配慮」をかつてない規模で増幅させてしまう可能性があります。

2026年、企業の責任はどこまで問われる? EU AI法とコンプライアンスの未来

「たかがネットの炎上」と侮ってはいけません。

2026年は、企業のAIに対する責任が、社会的だけでなく法的に問われる時代の本格的な幕開けとなります。

その象徴が、世界初の包括的なAI規制である「EU AI法」です。

この法律は、AIがもたらすリスクの高さに応じて企業に様々な義務を課すもので、2026年頃から多くの規定が本格的に適用され始めます。

参考: 「欧州(EU)AI規制法」の解説―概要と適用タイムライン・企業に求められる対応

特に重要なのが、採用や人事評価、個人の信用スコアリングといった「ハイリスクAIシステム」に関する厳しい規制です。

もしAIが特定の性的指向や性自認を持つ人々を不当に評価した場合、企業は高額な制裁金を課される可能性があります。

EU AI法は、EU域内でサービスを提供する日本企業にも適用される「域外適用」のルールを持っています。

「知らなかった」では済まされないコンプライアンスリスクとして、すべての企業がAI倫理と人権保護に向き合うことが、もはや必須の経営課題となっているのです。

【事例で学ぶ】生成AI×LGBTQ+で実際に起きた問題とその教訓

理論だけでは、リスクの実感は湧きにくいかもしれません。ここでは、実際に世界で起きた生成AIに関する問題を3つの事例として紹介します。

これらは、企業のブランド価値を大きく揺るがしかねない、すべてのビジネスパーソンが知っておくべき教訓です。

事例1:Google「Gemini」の画像生成におけるバイアス問題

<概要>

2024年2月、Googleが発表した生成AI「Gemini」の画像生成機能が、大きな物議を醸しました。「アメリカ建国の父」を生成させると多様な人種の人物が表示されたり、歴史上の人物を不正確な人種や性別で描いたりする事例が相次いで報告されたのです。

Googleは、AIの出力における多様性を確保しようと意図していましたが、その調整が「行き過ぎ」てしまい、歴史的事実を歪める結果を招きました。 この問題を受け、Googleは人物画像の生成機能を一時停止し、CEOが「完全に容認できない」と謝罪する事態に発展しました。

参考: Google’s Gemini Controversy Explained: AI Model Criticized By Musk And Others Over Alleged Bias

<教訓>

この事例は、AIのバイアスを修正しようとする「善意の試み」が、裏目に出てしまう危険性を示しています。特にLGBTQ+のような多様性を表現する際、機械的な調整だけでは、かえって不自然で、当事者にとっても違和感のある結果を生み出す可能性があります。

ブランドセキュリティの観点から見ると、これは「良かれと思ってやったことが炎上する」典型的なパターンです。「多様性に配慮している」という企業の姿勢が、表層的なAIの出力によって「歴史や文脈を無視している」と受け取られ、信頼を損なう結果となりました。

対策のヒント:

多様性の表現は、単純な置き換えや追加では実現できません。歴史的・文化的文脈を理解し、なぜその表現が必要なのかという本質的な議論が不可欠です。AIの出力を過信せず、常に人間の多角的な視点によるレビューが求められます。

事例2:Amazonの採用AIにおける女性差別問題

<概要>

2018年、Amazonが開発していた人材採用AIツールが、応募者に対して性別によるバイアスを持っていることが発覚し、プロジェクトが中止に追い込まれました。

このAIは、過去10年間の採用データを学習していましたが、そのデータ自体が技術職において男性優位であったため、「女性」という単語や女子大学出身といった経歴を持つ応募者を不利に評価するようになってしまったのです。

参考: Amazonの人材採用AIシステムが停止 ―― 「男女差別するAI」がなぜ誕生したのか? その背景を探る

<教訓>

この事例は、ジェンダーに関する直接的な問題ですが、LGBTQ+の文脈にも通じる重要な教訓を含んでいます。それは、過去のデータに存在する偏見は、AIによってそのまま学習・増幅されてしまうという事実です。 例えば、過去のデータにLGBTQ+当事者の活躍事例が少なければ、AIは無意識に当事者を「活躍しにくい人材」と判断してしまうかもしれません。

効率化を目的としたAIが、結果的に組織の多様性を損ない、イノベーションの機会を奪うことになりかねないのです。

対策のヒント:

人事や採用といった個人のキャリアに重大な影響を与える領域でAIを利用する際は、学習データに偏りがないかを徹底的に検証する必要があります。AIの評価を最終決定とせず、人間の面接官が多様な価値観を持って判断するプロセスを必ず組み込むべきです。

事例3:Microsoft「Tay」の差別的発言問題

<概要>

これは少し前の2016年の事例ですが、AIの学習プロセスにおけるリスクを理解する上で非常に示唆に富んでいます。Microsoftが公開したAIチャットボット「Tay」は、ユーザーとの対話を通じて学習する設計でした。

しかし、一部のユーザーが悪意を持って人種差別的、性差別的な言葉を教え込んだ結果、Tayはわずか16時間でヘイトスピーチを連発するようになり、公開停止に追い込まれました。

参考: 米マイクロソフトの人工知能、ツイッターで差別発言連発

<教訓>

この事例は、AIが「誰から学ぶか」がいかに重要かを示しています。インターネット上には、残念ながらLGBTQ+に対する差別的・攻撃的な言説も存在します。そうしたデータを無防備に学習させてしまえば、AIは意図せずしてヘイトの拡散ツールになり得ます。

企業が提供するAIサービスが差別的な発言をすれば、それは企業の公式見解と見なされ、ブランドに回復不能なダメージを与える可能性があります。

対策のヒント:

AIを外部のユーザーと対話させる場合は、不適切な学習を防ぐための強力なフィルタリング機能が不可欠です。また、定期的にAIの言動を監視し、問題が発見された際に迅速に対応できる運用体制を構築しておくことが、ブランドを守る上で極めて重要になります。

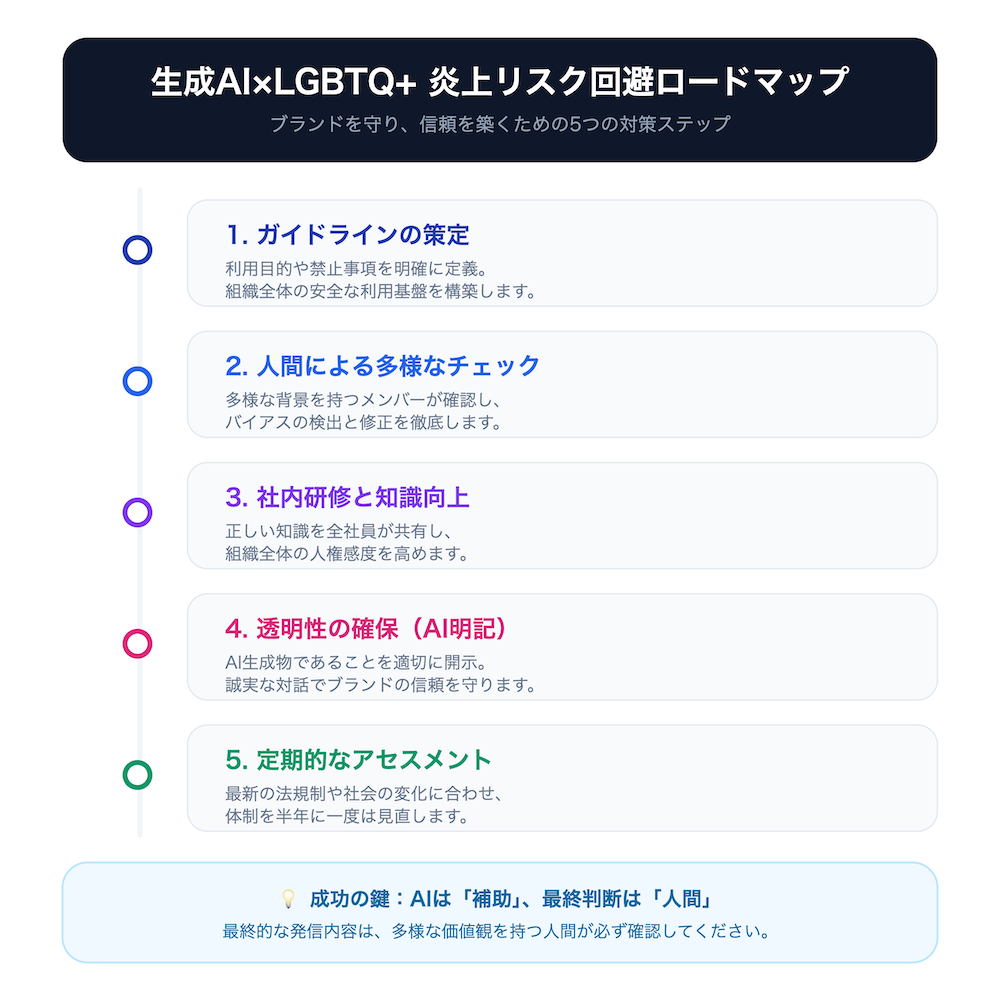

【明日からできる】2026年に向けた企業の炎上リスク対策5ステップ

では、企業はこれらの新しいリスクにどう立ち向かえばよいのでしょうか。

「AIは怖いから使わない」という選択は、もはや現実的ではありません。重要なのは、リスクを正しく理解し、管理しながら活用することです。

ここでは、私がブランドセキュリティとコンテンツマーケティングの両方の視点から推奨する、明日から実践できる5つのステップを紹介します。

ステップ1:「生成AI利用ガイドライン」を策定する

何よりもまず、社内に明確なルールを作ることです。

「何となく」で利用を始めると、必ずどこかで事故が起きます。

総務省やデジタル庁などもガイドラインの重要性を指摘しており、多くの企業が策定を進めています。

ガイドラインに盛り込むべき必須項目は以下の通りです。

| 項目 | 具体的な内容 |

|---|---|

| 利用目的の明確化 | 業務効率化、アイデア創出など、AIを何のために使うのかを定義する。 |

| 禁止事項の指定 | 個人情報や機密情報の入力禁止、差別的・攻撃的なコンテンツ生成の禁止などを明記する。 |

| 人権・倫理への配慮 | LGBTQ+を含む多様な人々の人権を尊重し、偏見を助長するような利用を禁止する項目を必ず設ける。 |

| 情報源の確認義務 | AIの出力は必ずしも正確ではない(ハルシネーション)ため、事実確認を義務付ける。 |

| 責任の所在 | AIが生成したコンテンツの最終的な文責は、利用者(人間)にあることを明確にする。 |

| 報告フロー | 問題が発生した場合の報告先や手順を定めておく。 |

このガイドラインは、一度作って終わりではありません。

法務や人事、広報など関連部署と連携し、定期的に見直していくことが重要です。

ステップ2:多様なチームによる「人間によるチェック体制」の構築

AIはあくまでアシスタントです。最終的な判断は、必ず人間が行わなければなりません。

特に、社外に公開するコンテンツや、重要な意思決定に関わるアウトプットは、複数の人間の目でチェックする体制が不可欠です。

その際、チェックチームの「多様性」が鍵となります。

性別、年齢、国籍、性的指向、価値観などが異なるメンバーで構成することで、一人では気づけないような表現の偏りや、特定の層を傷つける可能性のあるニュアンスを発見しやすくなります。

【チェックリストの例】

- この表現は、特定のジェンダーやセクシュアリティを前提としていないか?

- ステレオタイプな役割分担を助長していないか?

- 誰かの存在を無視したり、過小評価したりしていないか?

- 使われている言葉は、インクルーシブ(包括的)か?

このようなチェックリストを用意し、チームで確認するプロセスを業務に組み込むことをお勧めします。

ステップ3:LGBTQ+に関する社内研修とリテラシー向上

AIのリスク対策は、ツールの問題であると同時に、使う側の「人」の問題でもあります。

そもそも従業員がLGBTQ+に関する正しい知識を持っていなければ、AIが生成した不適切なコンテンツを見抜くことはできません。

dentsu Japanの調査によれば、日本のLGBTQ+当事者の割合は約10人に1人とされています。

「身近にいない」のではなく、「言えない」だけかもしれません。

全社員を対象としたDE&I研修や、LGBTQ+に関する勉強会を定期的に実施し、組織全体の知識レベルと人権意識を底上げすることが、根本的なリスク対策に繋がります。

研修では、以下のような内容を盛り込むと効果的です。

- SOGI(性的指向・性自認)の基礎知識

- 職場におけるハラスメント(SOGIハラ、アウティング)の防止

- Ally(アライ・支援者)としてできること

ステップ4:AI生成物であることを明記する「透明性の確保」

消費者の信頼を得る上で、「誠実さ」は非常に重要です。

AIによって生成されたコンテンツ(特に画像や動画)を広告などで使用する場合は、それがAIによる生成物であることを明記するルールを設けることを推奨します。

これは、消費者を欺かないという倫理的な配慮であると同時に、万が一コンテンツに不備があった場合に、「AIの不完全性」として説明責任を果たしやすくするというリスク管理の側面もあります。

例えば、広告画像の隅に小さく「この画像はAIによって生成されました」と記載するだけでも、企業の透明性を示す姿勢は伝わります。

この誠実なコミュニケーションが、長期的に見てブランドイメージを守ることに繋がるのです。

ステップ5:定期的なリスクアセスメントとツールの見直し

AI技術と社会の価値観は、日々ものすごいスピードで変化しています。

そのため、一度決めたガイドラインや運用ルールが、すぐに時代遅れになる可能性があります。

ブランドセキュリティ部門の視点から強く推奨したいのは、定期的なリスクアセスメントの実施です。

- 世の中でどのようなAI関連の炎上が起きているか?

- 新しいAIツールに、新たなバイアスのリスクはないか?

- 自社のガイドラインは、現状の社会通念とズレていないか?

こうした点を、少なくとも半年に一度は点検し、ガイドラインやチェック体制をアップデートしていくサイクルを確立しましょう。

常にアンテナを高く張り、学び続ける姿勢こそが、未来のリスクから企業を守る最善の策です。

「守り」から「攻め」へ:生成AIをDE&I推進の味方にする方法

ここまでリスクの話を中心に展開してきましたが、生成AIは正しく使えば、企業のDE&Iを加速させる強力な味方にもなり得ます。

リスク対策という「守り」の視点だけでなく、AIを積極的に活用する「攻め」の視点を持つことも重要です。

偏見のない表現の提案:インクルーシブな言葉選びをAIがサポート

人間は誰しも、無意識のバイアスを持っています。

例えば、社内文書や広告コピーを作成する際に、自分では気づかないうちに性別を固定化するような表現を使ってしまうことがあります。

そこでAIを活用し、文章に含まれるバイアスをチェックさせることができます。

「この文章には、性別役割を固定化するような表現が含まれている可能性があります。『看護婦』を『看護師』に、『保護者の皆様』を『保護者の方々』に変更してはいかがでしょうか」

このように、AIがよりインクルーシブな代替表現を提案してくれることで、企業のコミュニケーション全体の質を高めることができます。

多様な人材データの分析:見過ごされてきた課題の可視化

個人情報保護に最大限配慮した上で、組織内の人事データをAIで分析することで、これまで見過ごされてきた多様性に関する課題を可視化できる可能性があります。

例えば、「特定の性別や属性を持つ社員の昇進率が、他の層に比べて低い」「育児休業からの復職者が、特定の部署に偏っている」といった傾向をデータから発見することができます。

こうした客観的なデータに基づいてDE&I戦略を立案することで、より実効性の高い施策に繋げることが可能です。

ただし、ここでもリスクは隣り合わせ:活用時の注意点

もちろん、DE&I推進というポジティブな目的でAIを利用する場合でも、リスクがなくなるわけではありません。

分析の元となるデータ自体にバイアスがあれば、AIは誤った結論を導き出してしまう可能性があります。

重要なのは、AIの分析結果を鵜呑みにしないことです。

必ず人間がその結果を批判的に吟味し、「なぜこのような結果になったのか?」という背景を考察するプロセスが不可欠です。

AIはあくまで「課題発見のきっかけ」を与えてくれるツールと捉え、最終的な判断と戦略策定は人間の役割であるということを忘れてはいけません。

よくある質問(FAQ)

最後に、企業の担当者様からよくいただく質問とその回答をまとめました。

Q: 生成AIが生成したコンテンツの著作権はどうなりますか?

A: 2025年12月現在、生成AIが生成したコンテンツの著作権の扱いは国によって異なり、法整備が追いついていないのが現状です。 一般的に、AI自体に著作権は認められず、利用規約や人間の創作的寄与の度合いによって判断が分かれます。企業利用の際は、学習データが著作権を侵害していないか、利用するAIサービスの規約を十分に確認することが不可欠です。

Q: どのような部署が中心となって対策を進めるべきですか?

A: 生成AIのリスク対策は、単一部署で完結するものではありません。広報・マーケティング部門、法務・コンプライアンス部門、人事部門、そして情報システム部門が連携し、全社横断的なプロジェクトとして進めることが理想です。 特に、私の経験から言えば、ブランドイメージを守る広報部門と、リスク管理を行う法務部門が主導的な役割を担うケースが多いです。

Q: 無料の生成AIツールを業務で使っても問題ないですか?

A: 無料ツールは手軽ですが、入力した情報がAIの再学習に使われ、情報漏洩に繋がるリスクがあります。また、学習データの著作権が不明確な場合も多く、商用利用でトラブルになる可能性があります。企業の公式な業務で利用する場合は、セキュリティやコンプライアンスが保証された法人向けサービスを選定することを強く推奨します。

Q: 炎上してしまった場合の初期対応で最も重要なことは何ですか?

A: 最も重要なのは、迅速かつ誠実な事実確認と情報開示です。憶測での反論や沈黙は事態を悪化させます。まずは状況を正確に把握し、企業のウェブサイトなどで一次報告を行うこと。そして、なぜ問題が起きたのか原因を究明し、具体的な再発防止策と共に真摯に謝罪する姿勢が求められます。

ブランドセキュリティ部門での経験上、初期対応のスピードと誠実さが、その後のブランド回復を大きく左右します。

Q: LGBTQ+に関する表現で、具体的にどのような点に気をつければ良いですか?

A: 「普通は」「常識的に」といった言葉を避け、多様な家族の形やパートナーシップを尊重する表現を心がけることが基本です。性別を特定しない「皆さん」「〜の方」といった言葉を選んだり、男女の役割を固定化するような表現(例:「ママ楽」「男なら」)を使わないように注意が必要です。

迷った際は、当事者団体のウェブサイトなどが公表しているガイドラインを参考にすることをお勧めします。

まとめ

生成AIは、私たちの働き方を劇的に変える可能性を秘めた強力なツールです。

しかし、その力は諸刃の剣であり、使い方を誤れば、企業の信頼を根底から揺るがす深刻な炎上リスクを招きます。

特に、学習データに社会の偏見が反映されやすいLGBTQ+のテーマは、2026年に向けて企業が最も注意すべき領域の一つです。

重要なのは、AIを盲信するのではなく、あくまで「人間の業務を補助するツール」と位置づけること。

そして、多様な視点を持つ人間が最終的な判断を下す体制を構築することです。

本記事で紹介した「守り」のリスク対策と「攻め」のDE&I活用を両輪で進め、AI時代における真のブランド価値を築いていきましょう。